Richtig eingesetzt, trägt Künstliche Intelligenz (KI) zu einer Ausschöpfung von Gewinnpotenzialen und einer erheblichen Kosteneinsparung bei. Jedoch ist eine richtige Implementierung von KI-Prozessen keinesfalls einfach. Die hohe Komplexität stellt Geschäftsführer und Innovationsmanager vor Entscheidungen, die maßgeblichen Einfluss auf den Erfolg oder Misserfolg von KI-Projekten haben. Welche typischen Aspekte bei der Durchführung zu beachten sind und wie ein solches strategisches Vorgehen aussieht, werden in diesem Artikel dargestellt. Außerdem stellen wir das Modul „Deep Dive“ der CyberForum Akademie vor. Hier lernen Sie die richtige Heransgehensweise kennen, die Sie in die Lage versetzt, eine KI-Entscheidung zu treffen.

Die Entwicklung von Machine Learning-Modellen

in KI-Projekten

Mit KI-Projekten sollen Methoden der Künstlichen Intelligenz erfolgreich im Unternehmen implementiert werden. Aktuell stecken hinter diesen KI-Methoden meist Verfahren des maschinellen Lernens. Dabei werden Lernalgorithmen verwendet, die eigenständig Muster und Gesetzmäßigkeiten aus Trainingsdaten lernen. Typische Anwendungsfälle sind zum Beispiel in der Produktion im Qualitätsmanagement, im Finanzsektor bei der Prävention von Kreditkartenbetrug sowie bei Anwendungsfällen im Bereich der Sprach- und Texterkennung. Abstrakter lassen sich Machine Learning-Modelle einsetzen für:

- Quantitative und qualitative Vorhersagen

- Optimierung von Prozessen

- Anomalieerkennung

- Verarbeitung natürlicher Sprache

- und vieles mehr.

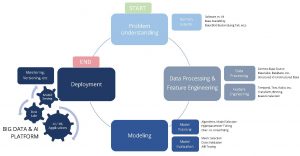

Der Data Science Lifecycle:

Die vier Phasen eines KI-Projektes

Der Data Science Lifecycle skizziert den sich wiederholenden Ablauf für die Entwicklung einsatzfähiger Machine Learning-Modelle (siehe Abb. 1). Das heißt die Phasen des Data Science Lifecycles entsprechen dem typischen Ablauf eines KI-Projektes. Die dargestellte Vorgehensweise kann auf jedes beliebige KI-Projekt übertragen und als Anhaltspunkt für die Anforderungen, die benötigten Rollen und Skillsets herangezogen werden.

1. Problem Understanding: Problemidentifikation mit Domänenexperte

Zielsetzung der Problemidentifikation ist es, sich einen Überblick über alle Anforderungen und vorhandenen Daten zu verschaffen. Anhand dieser Erkenntnisse wird entschieden, welcher Lösungsansatz verfolgt wird: datengetriebenes Machine Learning und folglich KI-Ansätze oder klassische Softwareentwicklung.

Vorgehensweise: Der Domänenexperte führt den Data Scientisten in die Problemstellung ein. Dabei werden das Problem sowie die gewünschte Lösung definiert. Der Domänenexperte erklärt die Natur der vorhandenen Daten wie

- triviale Abhängigkeiten

- numerische und kategorische Daten

- Messgrößen Einstellungen der Maschine.

Eine weitere wichtige Frage ist die Größe des vorhandenen Datensatzes. Ist der Tail der Datenverteilung gut verstanden und im Datensatz repräsentiert?

2. Datenvorverarbeitung & Feature Engineering

Bei der Datenvorbereitung und dem Feature Engineering sichtet und bereinigt der Data Scientist die vorhandenen Daten. Folgende Fragen können bei der Beurteilung des Datensatzes helfen:

- Sind alle Eingangsdaten (Features) in allen Datenpunkten vorhanden inklusive Plausibilitätscheck?

- Sollen Datenpunkte augmentiert werden?

- Kategorische Features müssen eingebettet werden, numerische

- Wie soll mit Ausreißern umgegangen werden?

- Existieren unnötige Features?

- Gibt es offensichtliche Abhängigkeiten in den Features?

- Was sind neue, aussagekräftige Features?

3. Modellauswahl, Modelltraining, Modellevaluation

Das ausgewählte Modell muss zum Problem und zur Natur der Daten passen. Wurde ein geeignetes Modell ausgewählt, werden die vorhandenen Daten aufgeteilt in Test-, Evaluations- und Trainingsdaten oder man verwendet andere Verfahren wie die Kreuzvalidierung. Dies ist nötig, um abzuschätzen wie gut das Modell die allgemeinen Muster gelernt hat oder ob es nur durch Auswendiglernen des Trainingsdatensatzes zum Ergebnis kommt. Die Modellkandidaten werden auf der Analytics Plattform mit dem Trainingsdatensatz trainiert. Die „fertigen“ Modelle werden dann mithilfe des Testdatensatzes bewertet. Dabei sind folgende Fragen zu klären:

- Welches Bewertungsmaß ist für die vorliegende Aufgabe am besten geeignet?

- Wurde ein „richtiges“ Muster im Training gelernt?

Ist das Ergebnis zufriedenstellend, so kann das Modell operationalisiert werden. Falls nicht, wird der Zyklus mit den gewonnenen Erkenntnissen ab Schritt zwei erneut gestartet.

4. Deployment

Beim Deployment wird das Modell aus Schritt drei in das produktive System des Unternehmens integriert. Der Machine Learning-Engineer stimmt das Deployment auf den jeweiligen Use Case ab. Eine wichtige Rolle spielen dabei die Skalierbarkeit sowie die Einfachheit eines Redeployments von Folgemodellen.

Für ein effizientes Deployment und für die spätere Nutzung von Machine Learning Methoden ist eine KI/Big Data Plattform, auch Analytics Plattform genannt, eine zwingende Voraussetzung. Im Folgenden sind die Anforderungen und Vorteile einer Analytics Plattform zusammengefasst:

Was sind die Vorteile einer Big Data/KI-Plattform?

- Daten müssen nicht pro Analyse mühsam beschafft, korrigiert und validiert werden, sondern stehen kontinuierlich „fertig zur Analyse“ und Use Case-übergreifend zur Verfügung.

- Ein Metadaten Store kann informative Eigenschaften und Zusammenhänge gespeicherter Daten Dies verhindert eine nutzlose Datensenke.

- Historische Daten sind verfügbar für Simulationen und optimierte Steuerung der Prozesse („Digital Twin“).

- Datensicherheit, Datenintegrität, Datenqualität können zentral gesichert werden.

Was sind die Anforderungen an eine Big Data/KI-Plattform?

- Große Datenbestände sollen „just in time“ zugänglich und bestenfalls mit Semantik versehen vorgehalten

- Daten müssen auf einer Analytics Plattform zugänglich und mit unterschiedlichen Technologien automatisiert bearbeitbar

- Entwickelte ML-Modelle müssen skalierbar, mit Realtime-Anforderungen und mit den nötigen Datenanbindungen in Betrieb genommen werden können.

- Einfache Skalierung hinsichtlich Datenmenge, Datendurchsatz und Use Cases.

Strategische Entscheidungen für eine erfolgreiche Umsetzung von KI- Projekten

1. Rollen und Skillsets identifizieren

Die Auswahl des richtigen Personals ist ein entscheidendes Erfolgskriterium für die Durchführung von KI-Projekten. Die verschiedenen Phasen des Data Science Lifecycles benötigen verschiedene Rollen mit unterschiedlichem Spezialwissen. Im ersten Schritt des Data Science Lifecycles, der sogenannten „Problemdefinition“, sollten deshalb alle erforderlichen Rollen, die jeweiligen Skillsets sowie die verwendeten Tools beschrieben und den einzelnen Phasen des Zyklus zugeordnet werden.Klassisch sind für die Durchführung von KI-Projekten die folgenden Rollen denkbar:

- Data Scientist

- ML-Engineer

- Domänenexperte

- Data Analyst

- Software Engineer

- KI-Manager

- Innovations-Manager

2. Make-or-Buy-Entscheidung

Für die Durchführung von KI-Projekten müssen vorab einige technische Voraussetzungen geschaffen werden. Dazu gehört

- die Bereitstellung eines Data Lakes, der notwendige Daten Use Case- übergreifend vorhält.

- einer Software-Umgebung für die Analyse der Daten und Training der

- einer KI/Big Data-Plattform für den Betrieb der entwickelten

Geschäftsführer müssen den Aufwand einer Eigen- und einer Fremderstellung abschätzen. Dabei sind vor allem die personellen und technischen Anforderungen zu berücksichtigen. Konkret heißt dies:

- Liegen im Unternehmen bereits alle benötigten fachlichen Kompetenzen vor?

- Sind alle technischen Rahmenbedingungen gegeben?

Dabei sollte beachtet werden, dass

- einerseits ein interner Know How Aufbau bei fehlenden Kompetenzen meist mit hohen Kosten verbunden

- aber andererseits ein Zukauf von Lösungen /Ressourcen von einem Drittanbieter in einer Abhängigkeit hinsichtlich des Know Hows, der Software, der Integration oder der Hardware resultieren

3. Auswahl eines geeigneten Anbieters

Auf dem Markt existieren viele KI-Anbieter, darunter große Beratungsfirmen, spezialisierte KMUs sowie Cloud und Hybrid Dienste. Um die Auswahl einzuschränken und den richtigen Anbieter für den eigenen Use Case zu identifizieren, sind Workshops eine sehr gute Methode. Während des Termins können Unternehmen sich beraten lassen, die Herangehensweise der Anbieter vergleichen und erhalten folglich eine erste Einschätzung über dessen Know How. Als Auftraggeber sollte man während des Gesprächs vor allem auf folgende Aspekte achten:

- Können die angebotenen Modelle nachtrainiert werden?

- Ist die Lösung skalierbar?

- Je nach Präferenz: Handelt es sich um eine Cloud-, Hybrid- oder On- Premises-Lösung? Besteht die Möglichkeit einer Containerisierung?

- Wie wird Vendor Lock-in vermieden?

- Wem gehören die Intellectual Properties? Wird Software lizenziert oder explizit entwickelt?

Jedes KI-Projekt ist aufgrund seiner Anforderungen und Zielsetzungen einzigartig. Den typischen Ablauf und die zu treffenden Kernentscheidungen kennen Sie nun. Für eine Vertiefung des Themas sowie wertvolle Praxistipps ist das Seminar „Deep Dive – Entscheidungsgrundlagen für KI- Projekte“ der CyberForum Akademie genau das richtige für Sie.

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Das Seminar findet als Online-Veranstaltung über Microsoft Teams an folgenden Terminen statt: 05.05.2021, 28.07.2021 und 10.11.2021, jeweils von 9 – 16 Uhr.

Zur Anmeldung: www.cyberforum.de/akademie/ki-weiterbildung/